支持向量机(Support Vector Machine,SVM)是一种经典的监督学习模型,广泛应用于分类、回归及异常检测等任务,尤其在小样本、高维数据的分类问题中表现优异。以下从核心原理、关键概念、扩展应用等方面详细介绍

一、核心原理:寻找最优分类超平面

SVM 的核心目标是在特征空间中找到一个最优分类超平面,使得两类样本被完美分隔,且离超平面最近的样本(支持向量)到超平面的距离(间隔)最大。

- 超平面:在 d 维特征空间中,超平面可表示为方程 w⋅x+b=0,其中 w 是法向量(决定超平面方向),b 是偏置(决定超平面位置)。

- 间隔(Margin):两类样本中离超平面最近的点到超平面的距离之和(即 “几何间隔” 的 2 倍)。SVM 的优化目标是最大化间隔,因为间隔越大,模型的泛化能力越强(对新样本的分类稳定性越高)。

- 支持向量(Support Vectors):离超平面最近的样本点,这些点决定了超平面的位置和方向,是模型的 “关键样本”。

二、关键概念与数学推导

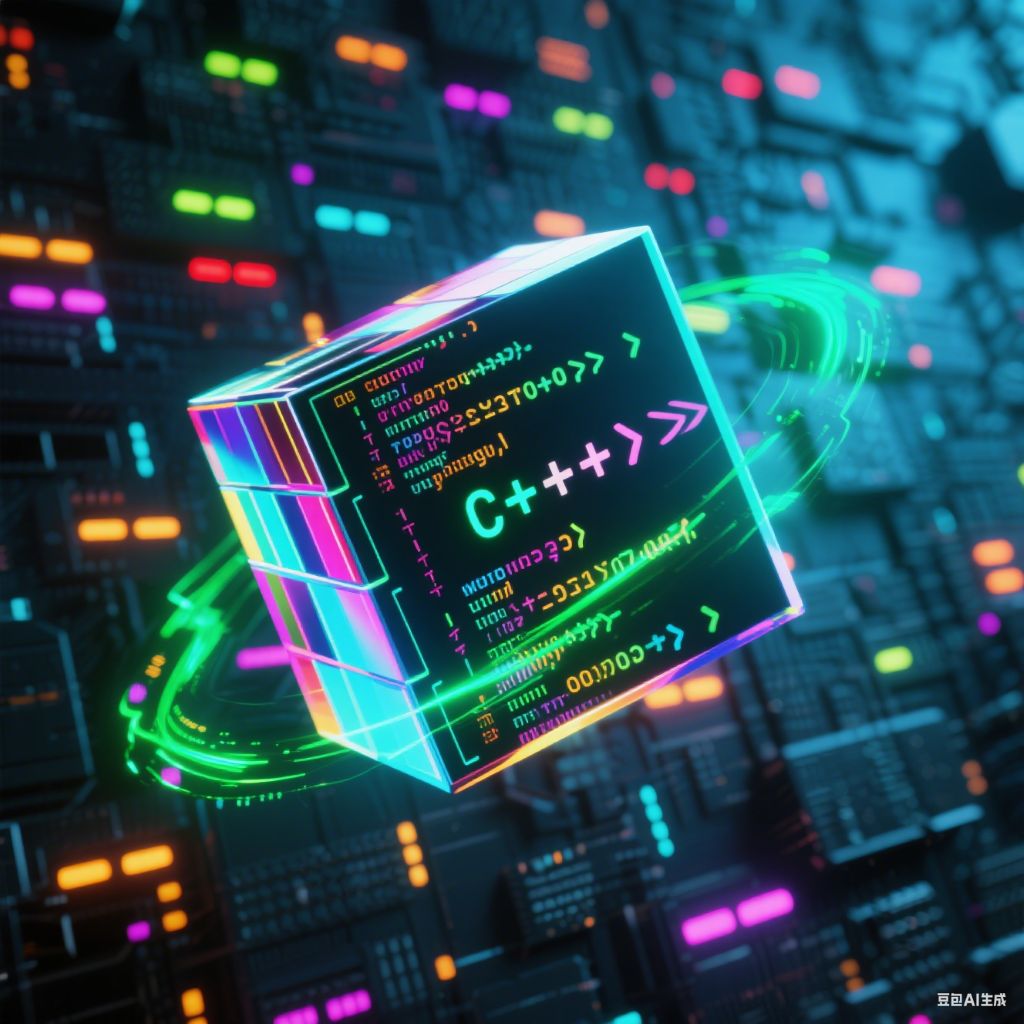

1. 线性可分情形

当两类样本在特征空间中线性可分时,SVM 通过求解以下优化问题找到最优超平面:

![图片[1]-支持向量机SVM-阿尔法欧欧](/robingo/%E6%96%87%E7%AB%A0%E8%B5%84%E6%BA%90/2025_08/1.png)

其中,yi∈{+1,−1} 是样本标签,xi 是样本特征向量。通过拉格朗日乘子法求解,最终超平面仅由支持向量决定,非支持向量对模型无影响。

2. 线性不可分情形与软间隔

实际数据往往线性不可分(存在噪声或重叠),此时引入软间隔(Soft Margin) 允许少量样本违反分类约束,通过惩罚系数控制容错程度:

![图片[2]-支持向量机SVM-阿尔法欧欧](/robingo/%E6%96%87%E7%AB%A0%E8%B5%84%E6%BA%90/2025_08/2.png)

- ξi:松弛变量,表示样本 xi 违反分类约束的程度(ξi=0 表示被正确分类)。

- C:惩罚系数(正则化参数),控制 “最大化间隔” 与 “最小化分类错误” 的平衡:

- C 过大:对错误的惩罚严格,易过拟合(模型更复杂,可能拟合噪声);

- C 过小:允许更多错误,模型简单,可能欠拟合。

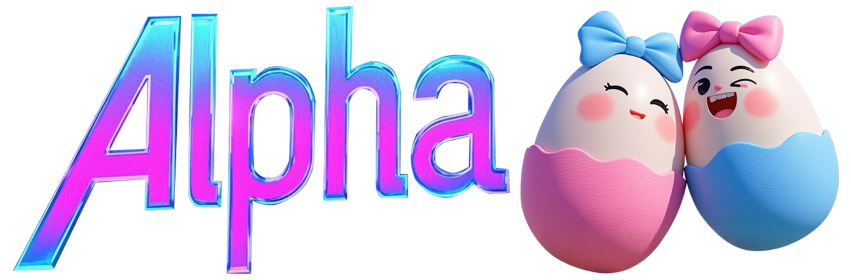

3. 核函数(Kernel Function):处理非线性问题

当样本在原始特征空间中线性不可分时,SVM 通过核函数将低维特征映射到高维特征空间,使高维空间中样本线性可分。核心思想是 “升维后线性化”,但通过核函数避免直接计算高维映射(降低计算量)。

常用核函数:

![图片[3]-支持向量机SVM-阿尔法欧欧](https://alphaoo.com/robingo/%E6%96%87%E7%AB%A0%E8%B5%84%E6%BA%90/2025_08/3.png)

三、SVM 的优缺点

优点:

- 小样本优势:通过最大化间隔,对小样本数据的泛化能力较强(相比需要大量数据的模型,如神经网络)。

- 高维适应性:在高维特征空间中表现稳定,不易受 “维度灾难” 影响(尤其结合核函数时)。

- 鲁棒性:仅由支持向量决定,对噪声不敏感(软间隔机制进一步增强)。

- 理论完备:基于统计学习理论,有严格的数学推导保证。

缺点:

- 计算复杂度高:训练时间随样本量增长显著(O(n3)),不适用于超大规模数据集(如百万级样本)。

- 核函数选择敏感:性能依赖核函数及参数(如 C、γ)的选择,需大量调参。

- 多分类支持弱:原生 SVM 仅支持二分类,多分类需通过 “一对多”“一对一” 等策略间接实现,效率较低。

- 解释性差:核函数映射后的数据空间难以直观解释,模型决策过程不透明。

四、典型应用场景

- 图像分类:如手写数字识别(MNIST 数据集)、图像目标检测(结合特征提取,如 HOG+SVM)。

- 文本分类:如垃圾邮件识别、情感分析(通过词袋模型将文本转为高维特征,SVM 处理效果优异)。

- 生物信息学:如基因序列分类、蛋白质结构预测(小样本、高维特征场景适配)。

- 异常检测:如信用卡欺诈检测(将正常样本作为一类,异常样本作为 “另一类”,利用 SVM 的间隔特性识别)。

五、实际使用建议

- 数据预处理:SVM 对特征尺度敏感,需先标准化(如归一化到 [0,1] 或标准化为均值 0、方差 1)。

- 特征降维:高维特征(如 1000 维)可先用 PCA/LDA 降维,减少计算量。

- 参数调优:通过网格搜索、贝叶斯优化等方法选择核函数及参数(如 RBF 核的 C 和 γ)。

- 工具库:优先使用成熟库,如 Scikit-learn(

sklearn.svm.SVC)、LIBSVM(高效实现,支持大规模数据)。

总结

SVM 是一种兼具理论深度和实践价值的经典模型,尤其在小样本、高维、非线性的二分类任务中表现突出。尽管在大数据场景中被深度学习替代,但在数据量有限或需要高泛化能力的任务中,仍是首选方案之一。

© 版权声明

2、文章版权归作者所有,未经允许请勿转载

3、本站资源定期维护,如发现链接失效,请与作者联系

4、本站一律禁止以任何方式发布或转载任何违法的相关信息,访客发现请向站长举报

5、本网站的文章部分内容可能来源于网络,仅供大家学习与参考,如有侵权,请联系站长进行删除处理

THE END

暂无评论内容